چطور Compression میتواند برای شناسایی اسپم و صفحات با کیفیت پایین به کار رود؟

مفهوم فشردهسازی به عنوان یک سیگنال کیفیت موضوعی است که بسیاری از افراد از آن بیاطلاعاند. اما برای کارشناسان سئو آگاهی از این موضوع میتواند بسیار مفید باشد. موتورهای جستجو میتوانند از قابلیت فشردهسازی صفحات وب برای شناسایی صفحات تکراری، صفحات با محتوای مشابه، و صفحات با تکرار کلمات کلیدی استفاده کنند که به بهبود رتبهبندی صفحات با کیفیت کمک میکند.

با وجود اینکه پژوهشهای موجود نشان دادهاند که ویژگیهای صفحه میتوانند برای شناسایی اسپم به کار روند، به دلیل عدم شفافیت عمدی موتورهای جستجو، نمیتوان با اطمینان گفت که این تکنیکها حتما در حال استفاده هستند.

فشردهسازی یا compression چیست؟

در علوم کامپیوتر، فشردهپذیری به میزان کاهش حجم یک فایل (دادهها) اشاره دارد که ضمن حفظ اطلاعات ضروری انجام میشود. هدف اصلی فشردهسازی، کاهش حجم داده برای صرفهجویی در فضای ذخیرهسازی و انتقال سریعتر آن در اینترنت است.

چگونه مشکلات کرالینگ گوگل را حل کنیم؟ بیشتر بخوانید!

خلاصه فشردهسازی

فشردهسازی با جایگزینی کلمات و عبارات تکراری با ارجاعات کوتاهتر انجام میشود و حجم فایل را به میزان قابل توجهی کاهش میدهد. موتورهای جستجو معمولا صفحات وب را فشردهسازی میکنند تا در مصرف فضای ذخیرهسازی و پهنای باند صرفهجویی کرده و سرعت بازیابی صفحات را بهبود بخشند.

این فرایند به شکل ساده به این صورت است:

- شناسایی الگوها: الگوریتم فشردهسازی متن را برای یافتن کلمات و عبارات تکراری اسکن میکند.

- استفاده از کدهای کوتاهتر: کدها و نمادها فضای کمتری نسبت به کلمات اصلی اشغال میکنند و باعث کاهش حجم فایل میشوند.

- ارجاعات کوتاه با استفاده از بیتهای کمتر: ارجاعاتی که نماد کلمات جایگزین شده را نشان میدهند، از داده کمتری نسبت به کلمات اصلی استفاده میکنند.

استفاده از فشردهسازی در شناسایی اسپم

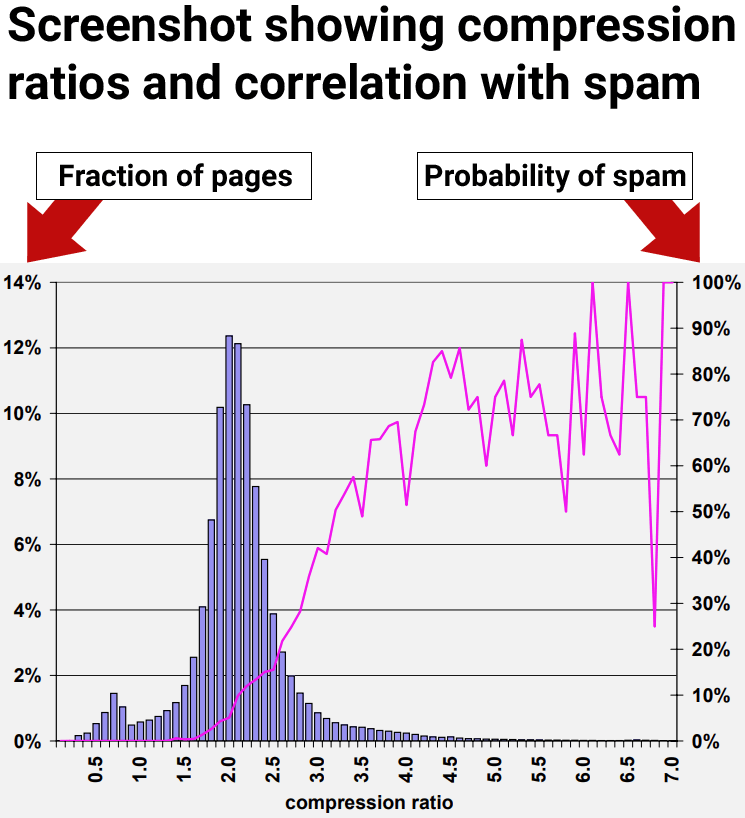

یکی از پژوهشهای کلیدی در این زمینه توسط دانشمندان مطرح حوزه کامپیوتر مانند مارک ناجورک و دنیس فِتِرلی انجام شده است. این پژوهشگران از فشردهپذیری به عنوان یک ابزار برای شناسایی اسپم استفاده کردند و به نتایج مهمی دست یافتند. در این پژوهش، آنها به این نتیجه رسیدند که صفحاتی با نسبت فشردهسازی بالا اغلب به عنوان صفحات اسپم در نظر گرفته میشوند.

تشخیص اسپم از طریق تحلیل محتوای صفحات وب

این پژوهش نشان داد که صفحاتی که محتوای تکراری و کلمات کلیدی را چندین بار تکرار میکنند، معمولا نسبت فشردهسازی بالایی دارند. برای مثال، صفحهای که یک کلمه خاص را ده بار تکرار میکند، ممکن است در موتورهای جستجو رتبه بهتری کسب کند، اما احتمال شناسایی آن به عنوان اسپم توسط موتورهای جستجو نیز افزایش مییابد.

محققان در بخشهایی از پژوهش، از الگوریتم GZIP برای فشردهسازی صفحات استفاده کردند و به این نتیجه رسیدند که هرچه نسبت فشردهسازی بالاتر باشد، احتمال اسپم بودن صفحه نیز بیشتر است.

تغییرات جدید هوش مصنوعی گوگل ادز!

ارتباط فشردهسازی بالا با اسپم

پژوهشگران دریافتند که ۷۰ درصد از صفحاتی با نسبت فشردهسازی حداقل ۴ اسپم شناخته شدند. اما استفاده از نسبت فشردهسازی به تنهایی نیز میتواند منجر به نتایج اشتباه شود، چرا که برخی صفحات غیراسپم نیز به اشتباه به عنوان اسپم شناخته میشوند.

ترکیب سیگنالهای مختلف برای دقت بیشتر

پژوهش نشان داد که استفاده از ترکیبی از سیگنالها به جای اتکا به یک سیگنال منفرد، دقت بیشتری در تشخیص اسپم دارد و از بروز نتایج اشتباه جلوگیری میکند.

نکات کلیدی برای سئوکاران

- صفحات درگاه با محتوای تکراری به راحتی توسط موتورهای جستجو به عنوان Spam شناسایی میشوند، زیرا نسبت فشردهسازی بالایی دارند.

- نسبت فشردهسازی بالای ۴ نشاندهنده صفحات با احتمال بالای اسپم است.

- استفاده از سیگنالهای منفی به تنهایی ممکن است منجر به نتایج اشتباه شود.

- سیگنال فشردهپذیری تنها به شناسایی اسپمهای مبتنی بر تکرار کمک میکند و انواع دیگر Spam را شناسایی نمیکند.

- ترکیب چند سیگنال منجر به افزایش دقت تشخیص اسپم و کاهش نتایج اشتباه میشود.

نتیجهگیری

سیگنال فشردهسازی ممکن است در شناسایی برخی از انواع Spam مفید باشد، اما استفاده از ترکیب سیگنالها بهترین راهکار برای تشخیص دقیق و جامع Spam است.

منبع: Search engine journal